원 핫 인코딩은 레이블 인코딩 후 진행한다.

Softmax

큰 숫자는 비중을 더 키워주고 작은 숫자는 비중을 더 작게 만들어 준다.

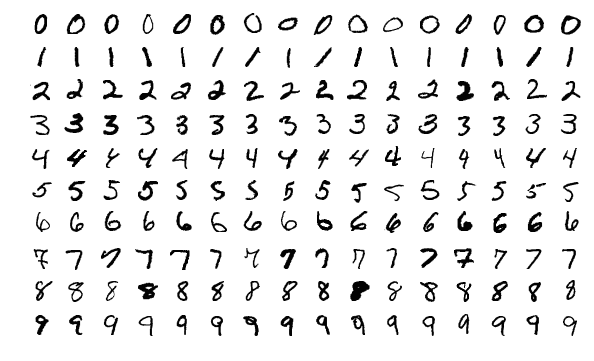

CNN(Convolutional Neural Networks)

컴퓨터 비전, 자연어처리도 할 수 있다.

피처를 뽑아내는 것이 중요하다.

피처 추출, 하나의 피처가 컬럼이 되어 딥러닝을 진행한다.

피처 추출이 컴퓨터 비전과는 다른다.

- Most widely userd for image classification

- Generally, it consists of convolution layer, pooling layer and fully-connected layer

- wieght(parameter, filter, kernel) sharing

- convolution, pooling layer - feature extraction

- fully connected layer classification

CNN에서는 0 padding을 사용한다.

그림이 급격하게 작아지는 것을 막는다.

pooling

피처의 수를 줄이기 위해 한다.

그레이 스케일에서는 평균 풀링을 사용하는 경우가 종종있다.

CNN은 특성(피처)울 추출하기 위함

RNN(Recurrent Neural Network)

이전 시점과 현재 시점의 정보를 가지고 학습을 한다.

이전 시점의 정보를 다음 정보의 데이터에 어떻게 넘겨주는지

federated learning

'AI > DL' 카테고리의 다른 글

| [빅리더_딥러닝_0728] (0) | 2021.07.28 |

|---|---|

| [빅리더_딥러닝_0727] (0) | 2021.07.27 |

| [딥러닝(Deep_Learning)] 신경망(Neural Network) (0) | 2021.07.26 |

| [딥러닝(Deep_Learning)] 퍼셉트론(Perceptron) (0) | 2021.07.26 |

| [빅리더_딥러닝_0726] (0) | 2021.07.26 |